File Robots.txt per migliorare la SEO del tuo sito web

Sai come usare i file Robots.txt per migliorare la SEO del tuo sito web? La stragrande maggioranza degli utenti di Internet utilizza Google quasi ogni giorno. Devono solo eseguire una ricerca e possono accedere a migliaia di fonti di informazioni. Ma come funzionano i motori di ricerca? Che cosa ha a che fare il file Robots.txt con le pagine di indicizzazione?

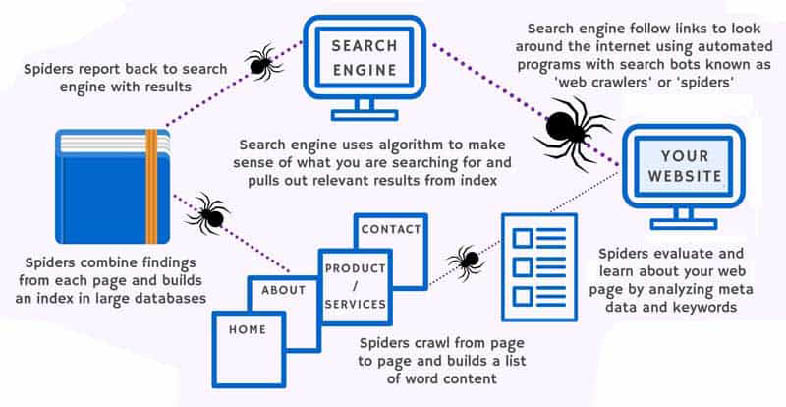

Qui la tecnologia dei motori di ricerca ha molto a che fare con questo. I robot sono responsabili del monitoraggio e dell’indicizzazione della maggior quantità di informazioni sulle pagine Web in modo che siano disponibili per gli utenti. Sebbene questa sia la loro funzione principale, i robot ne hanno molte altre. Ad esempio, gli spammer li usano per ottenere e-mail monitorando le pagine di contatto dei siti Web.

Allo stesso modo, vengono spesso utilizzati per individuare siti in XML o bloccare l’accesso a directory o file di codice. In ogni caso, questa tecnologia consente una migliore organizzazione dei contenuti Internet e una maggiore facilità di accesso ad essi.

Se vuoi che questi robot scansionino facilmente il tuo sito Web e ottengano le informazioni migliori, la cosa migliore che puoi fare è utilizzare i file Robots.txt per migliorare la SEO del tuo sito web.

Qual è il file Robots.txt?

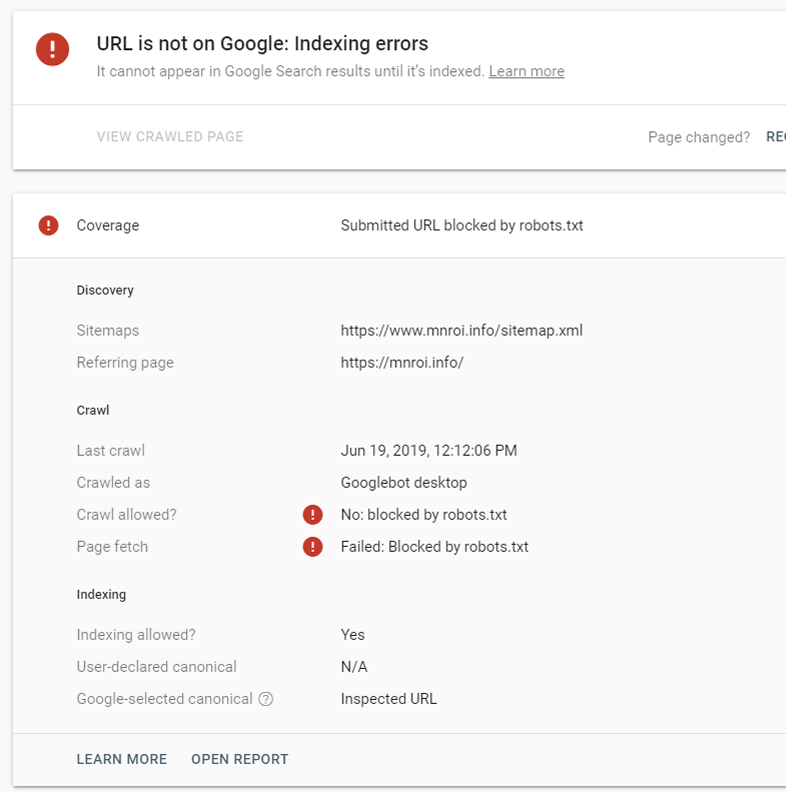

È fondamentalmente un file di testo semplice ospitato nella directory principale di un web. La sua funzione principale è quella di impedire ai robot di determinati motori di ricerca di tracciare determinati contenuti che il webmaster non desidera essere indicizzati o visualizzati nei risultati.

Cioè, è un file pubblico con estensione .txt che avvisa i crawler dei robot dove possono e non possono entrare in un web. In questo modo, puoi facilmente specificare directory, sottodirectory, URL o file che non desideri siano rilevati.

Ma quali sono gli elementi che il file robots.txt è in grado di indicizzare o no? È interessante sapere quali elementi possono essere raccolti in questi file, nonché quali sono i comandi più comunemente usati.

Come funziona il file Robots.txt

Il funzionamento dei file Robots.txt per migliorare la SEO del tuo sito Web è molto semplice. Quando crei una pagina web, tieni presente che Google e i vari crawler la esamineranno in un determinato momento per posizionarla.

Pertanto, è essenziale creare un file di testo all’interno del dominio per raccogliere in esso tutte le informazioni sulla pagina che ti interessa che Google conosca.

Ma serve anche a limitare l’accesso dei tracker ad altri tipi di informazioni. In parole di Google: “Un file robots.txt è un file che si trova nella radice di un sito e indica a quali parti non si desidera siano rilevate dai crawler dei motori di ricerca“.

Cioè, quando i robot di Google vanno a eseguire la scansione di un Web, la prima cosa che fanno è andare al file Robots.txt. Quindi, eseguiranno la scansione della pagina in base con i criteri specificati nel documento di testo.

Tieni presente che queste istruzioni non sono ordini ma una sorta di linee guida. I bot di Google possono, in qualsiasi momento, decidere di saltare una parte di queste direttive. Anche se è normale che i motori di ricerca rispettino i file Robots.txt.

Crea un file robots.txt

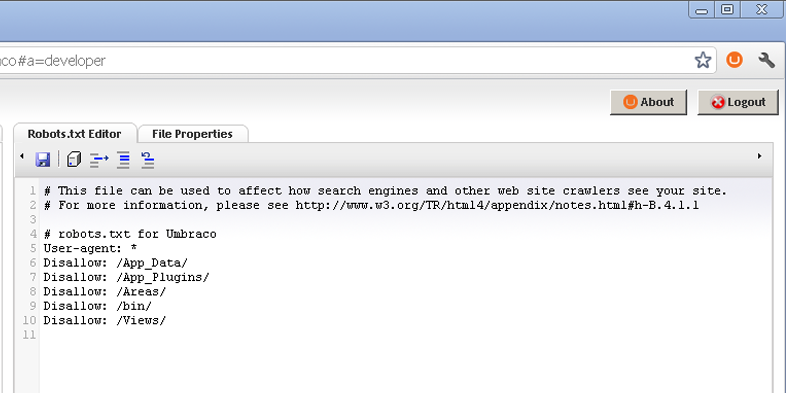

Per utilizzare i file Robots.txt per migliorare la SEO del tuo sito Web dovrai accedere alla directory principale del tuo dominio. Dovrai solo caricare il file in formato testo in modo che i motori di ricerca inizino ad accedervi.

Tuttavia, prima di dover scrivere un’intera serie di direttive e comandi in quel documento, sai quali sono gli elementi principali che compongono questo file e a cosa servono?

1.- User-agent

L’agente utente è l’identificatore dei robot di ciascun motore di ricerca. Ad esempio, gli spider di Google sono identificati come Googlebot. Allo stesso modo, i robot di Yahoo sono noti come Slurp e quelli di Bing sarebbero Bingbot.

Nel file Robots.txt vengono utilizzati per indicare a ciascun agente utente un gruppo di direttive. In questo modo, tutte le linee guida tra il primo e il secondo user-agent sono indirizzate al primo. Pertanto, le istruzioni possono essere indirizzate a diversi user-agent o essere applicate a tutti.

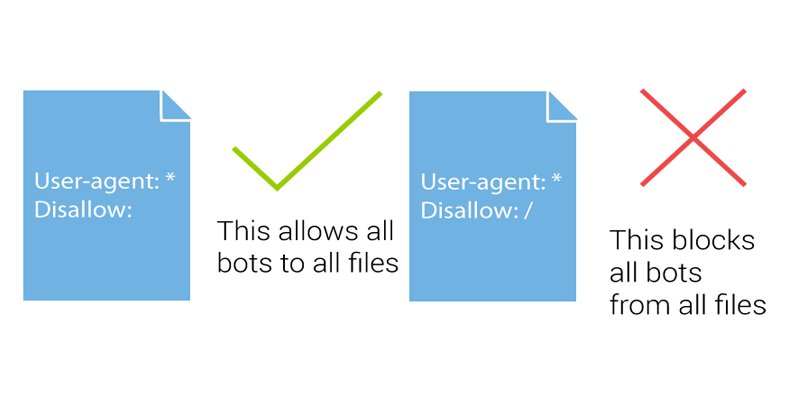

Se vuoi che tutti i motori di ricerca seguano il tuo sito web allo stesso modo, ti basterà utilizzare il comando “User-agent: *“. Quando si utilizza questa regola non è necessario scrivere direttive per ognuno.

2.- Non consentire l’accesso

La direttiva Disallow è esattamente quella utilizzata per dire ai crawler di non accedere a determinate parti del contenuto web. Per essere preso in considerazione, è necessario rilevare il percorso verso il quale non è possibile accedere. Se non si include il percorso specifico, la direttiva Disallow verrà ignorata e i robot accederanno all’intera directory.

3.- Consenti l’accesso

Questa direttiva è quella utilizzata per contrastare il Disallow. Cioè, è un modo per dire ai tracker di visionare una parte o una pagina specifica della directory che altrimenti non sarebbero visitabili.

4.- Mappa del sito

La mappa del sito è un altro elemento che dovrebbe essere raccolto dai file Robots.txt per migliorare la SEO del tuo sito web. È un elenco in cui compaiono tutti gli URL che compongono il sito, ed è il primo elemento che i motori di ricerca tracceranno durante l’accesso per comprendere la struttura delle pagine.

5.- Ritardo scansione

Questa direttiva viene normalmente utilizzata per impedire il sovraccarico dei server che hanno troppe richieste. Tuttavia, includere il crawl-delay nel file Robots.txt è semplicemente una soluzione temporanea. Se il tuo sito è generalmente sovraccarico, è a causa di un hosting di scarsa qualità o scarsa configurazione della pagina.

Nonostante ciò, dovresti sapere che il crawl-delay non è compatibile con Google, quindi non ti aiuterà a includerlo nei file Robots.txt per migliorare la SEO del tuo sito web. Per il resto dei motori di ricerca, tutti lo interpretano in modo diverso, quindi sarebbe necessario stabilire direttive personalizzate.

In che modo i file Robots.txt possono aiutarti a migliorare il tuo SEO web

A causa del suo ruolo importante nell’indicizzazione, i file Robots.txt sono molto utili per migliorare la SEO del tuo sito web. Puoi indicare ai motori di ricerca di indicare il modo migliore per tracciare il tuo sito web. Ed è qualcosa che puoi usare senza dubbio per migliorare il SEO della tua pagina.

La lettura del tuo sito Web verrà eseguita in modo molto più efficiente. Puoi includere direttive per impedire ai crawler di accedere a determinate parti del tuo sito web. Questo è uno dei modi migliori per evitare contenuti duplicati, ad esempio.

Anche se è meglio prestare attenzione a questo aspetto, poiché può anche rendere inaccessibili ai motori di ricerca alcune pagine del tuo sito. Pertanto, si consiglia di bloccare l’accesso alle pagine che i motori di ricerca non dovrebbero mai vedere, comprese le aree di accesso con URL o pagine di test diversi.

A.- Aumenta le visite al tuo sito web

Ricorda che stai aiutando i motori di ricerca a indicizzare la tua pagina in modo più efficace.

I crawler passano attraverso il web indicizzando tutto il contenuto disponibile. E questi file funzionano principalmente con le regole di accesso e di limitazione dell’accesso. Il motivo è che se queste linee guida non esistono, i robot comprendono che devono analizzare tutte le pagine di un sito.

Tuttavia, è possibile limitare l’accesso alle pagine non pertinenti alla propria strategia. In questo modo, contribuirai a evitare che il tuo server venga sopraffatto dai risultati dei motori di ricerca, il che alla fine si traduce in tempi di caricamento più lunghi o blocchi temporanei del sito.

B.- Elimina contenuti duplicati

Inoltre, questo protocollo di esclusione dei robot è molto efficace per evitare contenuti duplicati. Quest’ultimo può influire negativamente sul posizionamento organico di una pagina e i motori di ricerca possono penalizzarti in diversi modi:

- Filtraggio di contenuti duplicati in modo che non vengano visualizzati nei risultati.

- Google penalizza automaticamente le pagine che hanno contenuti duplicati con l’algoritmo Panda.

- Google può anche agire manualmente esaminando questi contenuti duplicati se è stato ricevuto un reclamo di plagio.

C.- Evitare di indicizzare i file di immagine

Avere file Robots.txt per migliorare la SEO del tuo sito Web ti consente anche di controllare alcuni elementi importanti. Soprattutto, immagini e infografiche che si desidera utilizzare come elemento per attirare visitatori.

Se impedisci alle immagini di apparire nei risultati e hanno un grande valore informativo, è possibile che gli utenti accedano alla tua pagina per visionarle. Anche se tieni presente che se sono collegati direttamente da altri siti, Robots.txt non impedirà agli utenti di arrivare attraverso questi collegamenti.

In Antevenio ti aiutiamo a creare una strategia di posizionamento efficace migliorando il posizionamento organico del tuo sito Web attraverso collegamenti di qualità. Contattaci e richiedi maggiori informazioni.